클라우드와 데브옵스의 세계를 함께 탐험하고 있는 여러분, 만나서 정말 반가워요. 😃

최근 몇 년 사이 우리가 일하는 방식이 정말 눈부시게 변했죠? 불과 얼마 전까지만 해도 YAML 파일을 한 땀 한 땀 수정하며 쿠버네티스 설정을 잡느라 밤을 지새우곤 했는데, 이제는 인프라 운영의 패러다임이 완전히 새로운 국면을 맞이하고 있어요. 오늘은 2026년 현재, 가장 뜨거운 감자인 ‘자율형 클라우드 운영’과 이를 뒷받침하는 LLMOps(대규모 언어 모델 운영)의 실체에 대해 깊이 있게 이야기해보려 합니다.

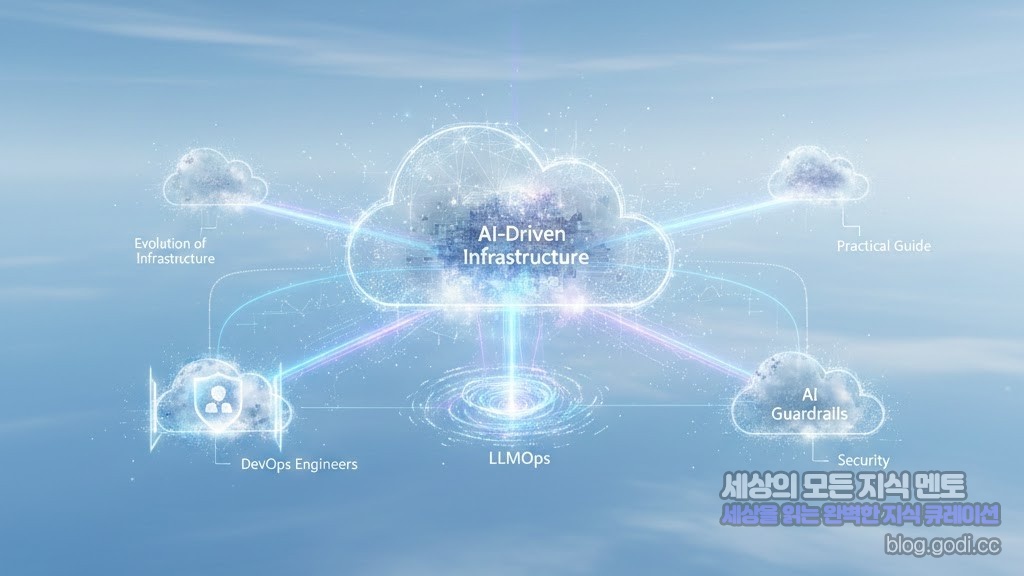

1. 인프라의 진화: IaC를 넘어 AI-Driven Infrastructure로

우리는 그동안 코드로 인프라를 관리하는 IaC(Infrastructure as Code) 시대에 살았습니다. 테라폼(Terraform)이나 헬름(Helm) 차트를 만지는 것이 데브옵스 엔지니어의 숙명이었죠. 하지만 이제는 인프라가 스스로 최적의 상태를 판단하고 구성하는 AI 기반 인프라가 대세가 되었어요.

이걸 조금 더 쉽게 설명해 드릴게요. 예전에는 레고 성을 만들기 위해 조립 설명서(코드)를 직접 써야 했다면, 이제는 인공지능에게 “바닷가 옆에 튼튼한 성을 지어줘”라고 말만 하면 AI가 지형을 분석하고 가장 튼튼한 블록을 골라 성을 완성하는 단계에 이른 거예요. 🏰

💡 핵심 요약: 2026년의 클라우드는 단순히 자동화된 스크립트를 실행하는 것을 넘어, 비즈니스 목적에 맞춰 인프라 자원을 스스로 동적으로 할당하는 지능형 시스템으로 진화했습니다.

2. LLMOps, 왜 데브옵스 엔지니어가 알아야 할까요?

요즘 어딜 가나 AI 이야기가 빠지지 않죠? 특히 기업 내부 데이터를 학습시킨 LLM(Large Language Model)을 실제 서비스에 배포하고 운영하는 LLMOps는 이제 데브옵스 팀의 핵심 업무가 되었습니다. 단순히 모델을 만드는 것을 넘어, 모델이 지속적으로 정확한 답변을 내놓을 수 있도록 관리하는 과정이 필요하기 때문이에요.

“LLMOps가 정확히 뭔가요?”라고 물으신다면, 저는 ‘AI 모델을 위한 전용 공장 라인’이라고 설명하고 싶어요. 🏭 공장에서 제품을 찍어낼 때 원료(데이터)를 검수하고, 기계(모델)가 잘 돌아가는지 모니터링하며, 불량품(잘못된 답변)이 나오면 바로 수정하는 전체 공정을 시스템화하는 것이죠.

- 데이터 파이프라인 최적화: 실시간으로 유입되는 데이터를 벡터 데이터베이스(Vector DB)에 효율적으로 적재하는 기술이 필수적입니다.

- 모델 서빙 가속화: GPU 자원은 여전히 귀하고 비싸죠. AWS의 Inferentia나 GCP의 TPU를 활용해 모델 응답 속도를 극대화하는 설정이 중요해요.

- 지속적 평가(Continuous Evaluation): AI 모델은 시간이 지나면 성능이 변할 수 있어요. 이를 감지하고 자동으로 재학습(Retraining)하는 파이프라인을 구축해야 합니다.

처음 접하면 “내가 이제 모델 성능까지 체크해야 하나?” 하고 당황스러우실 수 있어요. 하지만 걱정 마세요. 우리가 기존에 CI/CD를 관리하던 감각을 AI 모델에 적용한다고 생각하면 훨씬 마음이 편해지실 거예요.

3. 클라우드 네이티브의 새로운 보안, ‘AI 가드레일’

인프라가 똑똑해지는 만큼 보안의 영역도 확장되었습니다. 2026년의 클라우드 구축에서 가장 강조되는 것 중 하나가 바로 AI 가드레일(Guardrails) 설정이에요. AI가 인프라를 직접 제어하다 보니, 혹시라도 잘못된 명령을 내리거나 기밀 데이터가 외부로 유출되는 사고를 막아야 하거든요.

이것은 마치 ‘자율주행 자동차의 안전장치’와 같습니다. 🚗 차가 스스로 운전하지만, 갑자기 중앙선을 넘으려 하면 강제로 핸들을 꺾거나 브레이크를 밟는 장치가 필요한 것과 같은 이치예요.

구체적으로 어떤 기술들이 쓰일까요?

- 실시간 프롬프트 필터링: 부적절한 명령어가 입력되면 인프라 실행 단계에서 차단합니다.

- 데이터 익명화 기술: 클라우드 로그나 학습 데이터에 포함된 개인 정보를 실시간으로 마스킹 처리합니다.

- 권한 최소화 원칙(PoLP): AI 에이전트에게 필요한 최소한의 IAM 권한만 부여하여 만약의 사고를 방지합니다.

4. 실전 가이드: 지금 바로 준비해야 할 3가지

그렇다면 급변하는 이 시점에 우리는 무엇을 준비해야 할까요? 제가 추천하는 세 가지 실천 로드맵을 정리해 보았습니다.

- 첫째, GPU/NPU 리소스 오케스트레이션 공부하기: 이제 CPU와 메모리만 관리해서는 부족합니다. 쿠버네티스 환경에서 GPU 분할(Multi-Instance GPU) 기술을 통해 자원을 효율적으로 나누는 법을 익혀보세요.

- 둘째, 벡터 데이터베이스(Vector DB)와 친해지기: Pinecone이나 Milvus 같은 데이터베이스는 이제 클라우드 구축의 필수 요소입니다. 이를 AWS나 GCP 환경에서 어떻게 고가용성으로 구성할지 고민해 보세요.

- 셋째, 자연어 기반 인프라 정의(Natural Language IaC) 경험해 보기: “웹 서버 3대를 서울 리전에 띄워줘”라고 명령하면 테라폼 코드를 생성해 주는 에이전트 도구들을 적극적으로 사용해 보며 익숙해지는 것이 중요합니다.

마치며: 변화를 즐기는 데브옵스가 되시길 바라요

새로운 기술이 쏟아지는 시기에는 가끔 “내가 뒤처지는 건 아닐까?” 하는 불안감이 들기도 하죠. 하지만 여러분, 기억하세요. 기술의 이름은 바뀌어도 ‘효율적이고 안정적인 서비스를 만들고 싶다’는 우리의 본질적인 목표는 변하지 않습니다.

지금까지 우리가 쌓아온 인프라 운영 경험은 AI 시대에도 강력한 무기가 될 거예요. 복잡한 설정을 AI에게 맡기고, 우리는 더 가치 있는 아키텍처 설계와 비즈니스 논리에 집중할 수 있는 시대가 온 것이니까요. 오늘 이야기가 여러분의 클라우드 여정에 작은 나침반이 되었기를 바랍니다. 🌟

요약하자면:

- 2026년 클라우드는 자율형 인프라와 LLMOps가 핵심입니다.

- AI 모델의 생애 주기를 관리하는 공정(LLMOps)은 데브옵스의 필수 역량이 되었습니다.

- 기술의 변화를 두려워하기보다, AI를 강력한 운영 도구로 활용하는 마인드셋이 필요합니다.

함께 성장하는 즐거움을 잊지 마세요! 😊